09 de fevereiro de 2025 • 1 min de leitura

WSL2 + Ollama + DeepSeek + Open WebUI

Como rodar o DeepSeek local no WSL2 via Ollama e acessar a interface da Open WebUI via navegador

Configurações

# Acesse o /etc/wsl.conf com o nano

sudo nano /etc/wsl.conf

# Adicione os valores abaixo para habilitar o gerenciador de serviços no WSL2

[boot]

systemd=true

# Ctrl + X, seleciona Y para salvar alteração e Enter para confirmar o nome do arquivo

# No PowerShell, use o comando para reiniciar as instâncias do WSL:

wsl.exe --shutdownInstalação do Ollama

# Abrindo novamente o WSL2, instale o Ollama:

curl -fsSL https://ollama.com/install.sh | sh

# Tente rodar o commando "ollama" no terminal

ollama

# Deverá aparecer:

# Usage:

# ollama [flags]

# ollama [command]

# Available Commands:

# serve Start ollama

# create Create a model from a Modelfile

# show Show information for a model

# run Run a model

# stop Stop a running model

# pull Pull a model from a registry

# push Push a model to a registry

# list List models

# ps List running models

# cp Copy a model

# rm Remove a model

# help Help about any command

# Flags:

# -h, --help help for ollama

# -v, --version Show version information

# Use "ollama [command] --help" for more information about a command.Instalação do DeepSeek

# Tendo o Ollama instalado, faça o pull do DeepSeek:

ollama pull deepseek-r1

# Para verificar se o DeepSeek foi baixado, use o comando:

ollama list

# Deverá aparecer:

# NAME ID SIZE MODIFIED

# deepseek-r1:latest 0123abc 4.7 GB 1 hours ago

# ou acesse http://127.0.0.1:11434/api/tags para visualizar no navegadorInstalação da Open WebUI

# Tendo o Docker instalado, faça o pull da Open WebUI:

docker run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main-

Acesse a interface da Open WebUI no navegador http://localhost:8080

-

Nas configurações de conexão, ajuste para que a conexão do Ollama API seja: http://127.0.0.1:11434

-

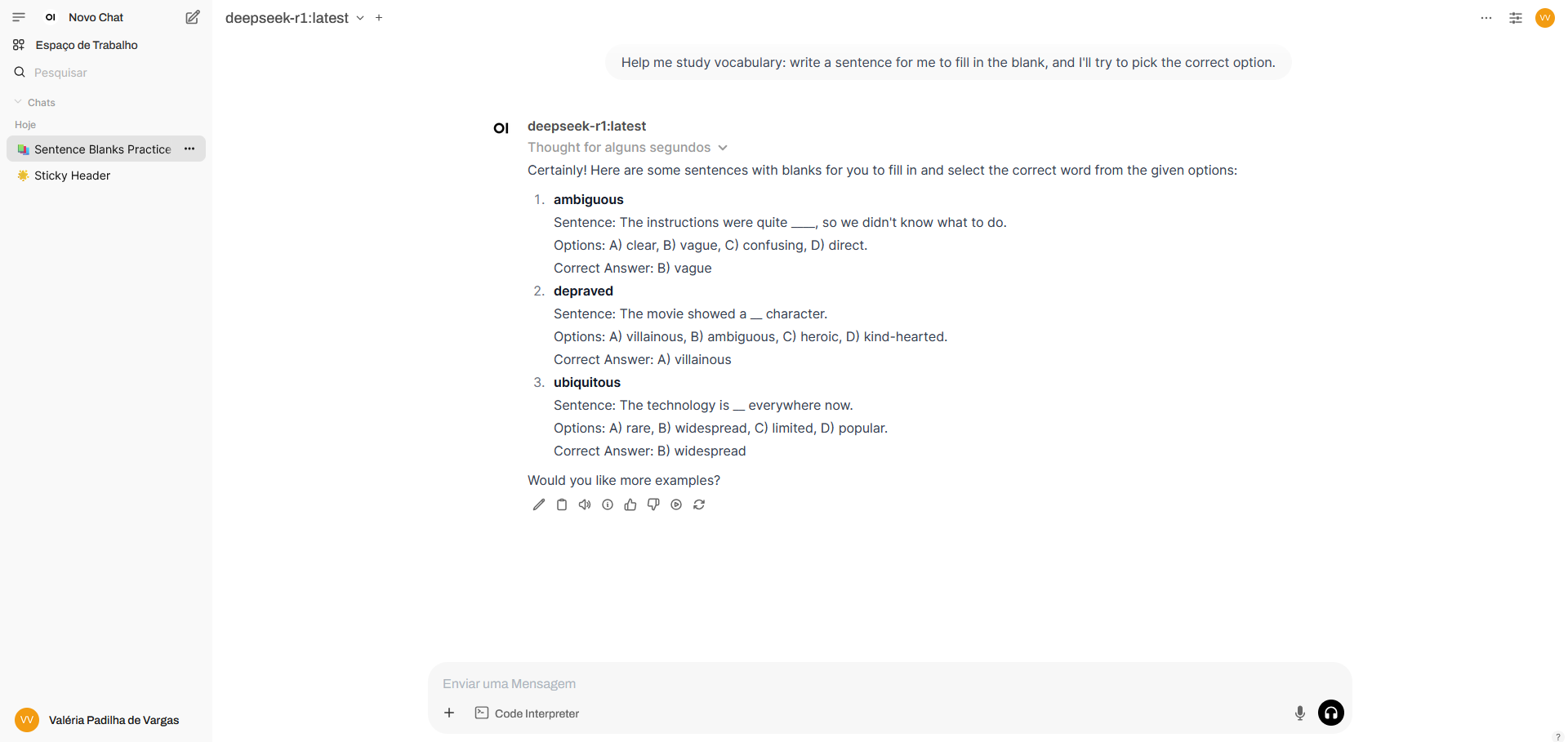

Utilizando o DeepSeek na interface da Open WebUI

Fontes: